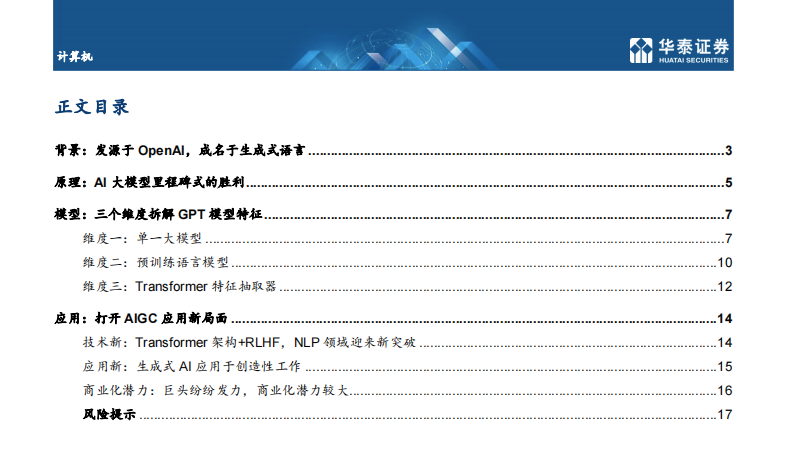

近期由 OpenAI 团队发布的聊天机器人软件 ChatGPT,凭借类人的语言理 解和表达能力,引发 AI 产业范式革命。

OpenAI 是一家世界领先的非营利性人工智能研究公司。

OpenAI 于 2015 年在旧金山成立, 是一家非营利的人工智能研究公司,公司的目标是以最有可能造福全人类的方式推进人工 智能,而不受财务回报需求的约束。OpenAI 创始人背景深厚,由埃隆·马斯克与硅谷孵化器 Y Combinator 投资人山姆·阿尔特曼等人联合创立。公司研究人员经验丰富,包括前 Google Brain 研究科学家伊利亚·苏茨凯弗与前 Stripe 首席技术官格雷格·布罗克曼等世 界一流研究工程师与科学家。

微软持续增资,布局生成式 AI 技术。

2018 年,随着特斯拉对 AI 的应用深入,为避免潜在利益冲突,马斯克主动离任董事会,仅保留捐资人和顾问的身份。由于 AI 训练花费金额巨大,2019 年公司从非营利性公司转向部分盈利公司,成立了 OpenAI LP 利润上限子公司,即任何对 OpenAI LP 投资的收益都将统一转移至一家非盈利公司,回报达到投资的 100 倍后进行利润分配。

同年,OpenAI 收到微软注资 10 亿美元,就 Azure 业务开发人工智能技术。2020 年发布 GPT-3 语言模型,由微软获得独家授权。2022 年发布 ChatGPT 的自然语言生成式模型,带来更大潜在应用空间。2023 年,微软拟对 OpenAI 追加数十亿美元投资,利用自身算力基础设施资源发挥与 OpenAI 业务协同效应,深入布局生成式 AI 技术。

OpenAI 当前盈利主要通过付费 API 接口,并尝试拓展盈利模式。

目前,OpenAI 提供API 数据接口根据类型不同以流量收费。OpenAI API 盈利情况较好,据路透社数据,OpenAI 2022 年收入数千万美元,公司预计 2023 与 2024 年收入分别为 2 亿美元和 10 亿美元。同时,OpenAI 正尝试拓展自身盈利模式,2023 年 1 月试点推出订阅制 ChatGPT Plus,收取每月 20 美元的会员费以得到各类优先服务。

原理:AI 大模型里程碑式的胜利

ChatGPT 采用监督学习+奖励模型进行语言模型训练。

ChatGPT 使用来自人类反馈的强化学习 (RLHF) 来训练该模型。首先使用监督微调训练了一个初始模型:人类 AI 训练员提供对话,他们在对话中扮演双方——用户和 AI 助手。其次,ChatGPT 让标记者可以访问模型编写的建议,以帮助他们撰写回复。最后,ChatGPT 将这个新的对话数据集与原有数据集混合,将其转换为对话格式。具体来看,主要包括三个步骤:

1)第一阶段:训练监督策略模型。在 ChatGPT 模型的训练过程中,需要标记者的参与监督过程。首先,ChatGPT 会从问题数据集中随机抽取若干问题并向模型解释强化学习机制,其次标记者通过给予特定奖励或惩罚引导 AI 行为,最后通过监督学习将这一条数据用于微调 GPT3.5 模型。

2)第二阶段:训练奖励模型。这一阶段的主要目标,在于借助标记者的人工标注,训练出合意的奖励模型,为监督策略建立评价标准。训练奖励模型的过程同样可以分为三步:1、抽样出一个问题及其对应的几个模型输出结果;2、标记员将这几个结果按质量排序;3、将排序后的这套数据结果用于训练奖励模型。

3)第三阶段:采用近端策略优化进行强化学习。近端策略优化(Proximal Policy Optimization)是一种强化学习算法,核心思路在于将 Policy Gradient 中 On-policy 的训练过程转化为Off-policy,即将在线学习转化为离线学习。具体来说,也就是先通过监督学习策略生成 PPO模型,经过奖励机制反馈最优结果后,再将结果用于优化和迭代原有的 PPO 模型参数。往复多次第二阶段和第三阶段,从而得到参数质量越来越高的 ChatGPT 模型。

EA之家 » ChatGPT:深度拆解